文 | AI大模型工场,作者|参商,编辑|星奈

最近,关于Scaling Law是否失效的讨论居高不下。

起因是The Information、路透社和彭博社接连爆出LLM进展放缓,Scaling Law撞墙。

The Information表示,据OpneAI内部人员透露,GPT系列模型更新缓慢,即将推出的下一代旗舰模型Orion并没有实现质的飞跃,虽然性能上超过了以往模型,但相较于从GPT-3到GPT-4的迭代,改进幅度缩小,OpenAI正在转变策略。

路透社也发文表示,由于当前方法受到限制,OpenAI和其他公司正在寻求通向更智能AI的新途径。

随后,彭博社也出来拱火,认为OpenAI、谷歌、Anthropic三家AI公司,在新模型开发上的付出与回报的差额正在逐渐扩大。

报道称,谷歌即将推出的新版Gemini并未达到内部预期,Anthropic也推迟了备受期待的Claude 3.5「超大杯」Opus的发布时间。

尽管,后面山姆.奥特曼亲自下场辟谣:没有墙。微软AI主管Mustafa Suleyman也表示,不会有任何放缓。

但不争的事实是,模型界“三巨头”在预训练方面接连碰壁,模型发展遇到瓶颈。Scaling Law的边界真的已经到来了吗?

一、暴力美学失效

Scaling Law也称尺度定律,被业界认为是大模型预训练第一性原理。

2020年,OpenAI发布论文“Scaling Laws for Neural Language Models”,首次发现模型参数量、数据集大小、训练计算量的关系,即三者中任何一个因素受限时,Loss与其之间存在幂律关系,其中一些趋势跨越了超过七个数量级。

也就是说,模型能力会随着参数量的增加而不断提升。OpenAI沿着这个思路也确实大获成功,在论文发布四个月后,GPT3问世,再到2022年ChatGPT上线,后面的故事大家都已经清楚。

从GPT3到GPT4,从Gemini到Claude,Scaling Law的暴力美学被一次次证明其正确性。

不过,随着模型参数不断增加,对数据量的需求也是指数级增长,人类互联网产生的数据迟早有一天会被大模型“吞噬”,只是这一天来得如此之快。

The Information指出,OpenAI下一代ChatGPT 5的训练出现了重大瓶颈,原因之一是高质量文本数据越来越少。

下一代要发布的旗舰模型Orion,在预训练阶段只用了20%的训练量,就达到了GPT4的水平,能力上升的很快,但OpenAI的研究者发现,后边增加训练量,Orion的水平提升却很慢很微小,没有实现从GPT3到GPT4的质得飞跃,这或许也是OpenAI并没有将Orion命名为GPT5的原因。

谷歌和Anthropic也面临着相同的问题,谷歌的下一代Gemini 模型表现低于内部预期,Anthropic Claude 3.5 Opus 的发布也将推迟。

国内,10月初,就有消息传出,“AI六小虎”中已经有两家公司已经决定逐步放弃预训练模型,近期又有消息指出,仍在继续预训练的公司只剩下智谱AI和MiniMAX,其他包括月之暗面、百川只能在内的公司都已经放弃预训练。

除了这些AI初创公司,国内的BAT包括字节这些大厂对预训练的进展并没有披露过多,都在卷向应用层。

实际上,国内模型厂商转向应用也从侧面印证了大模型Scaling Law目前存在的困境。

LLM除了吞噬了大量的数据外,在训练过程中所消耗的大量算力、电力等能源也成为严重阻碍,此外更为重要的是,超大规模的前期投入与收益无法匹配,ROI过低。

OpenAI研究者Noam Brown前段时间曾公开表示,更先进的模型可能在经济上不可行。“毕竟,我们真的要花费数千亿美元或数万亿美元训练模型吗?”Brown 说,“在某个时候,scaling 范式会崩溃。”

超大规模语言模型的预训练过程极其耗费资源,通常需要数十万张GPU并行运行数月之久,单次训练成本可达数千万至数亿美元。例如,拥有1.8万亿参数的ChatGPT 4模型,其单次训练费用大约为6300万美元。

然而尽管投入巨大,这些新模型在性能上的提升却与之前的模型性能所差无几,这种情况下,大模型公司下一轮的融资故事恐怕难以讲下去。

目前,以OpenAI为代表的初创企业,现在并没有跑通商业模式,投资人的钱也不是大风刮来的,如果长时间看不到回报,他们对继续投资的态度肯定会更加谨慎。毕竟,没有那个投资人原意一直当“冤大头”。在这种情况下,国内大模型行业整体转向了更符合商业利益的做法——做AI应用。

另外从技术角度看,整个AI行业还有另一个转向——从预训练向推理转向。

Scaling Law的忠实追随者OpenAI前首席科学家Ilya Sutskever,在最近接受路透社采访时表示,扩大预训练的结果已经达到了平台期。

“现在重要的是「扩大正确的规模」”他表示,“2010年代是scaling的时代,现在,我们再次回到了奇迹和发现的时代。每个人都在寻找下一个奇迹。”

二、大厂转向推理层,寻找新的Scaling Law

面对大模型Scaling Law降速的事实,各巨头纷纷寻找新的扩展定律。

事实上,目前讨论的Scaling Law撞墙更多的是指预训练扩展定律(Pre-training Scaling Law),也就是上文讨论的大模型暴力美学。

但是有关后训练和推理的Scaling Law还未被充分挖掘,这也是诸多大佬认为Scaling Law没有失效的重要原因。

后训练扩展定律(Post-training Scaling Law)与传统的预训练扩展定律不同,关注的是在模型训练完成后,如何通过增加推理阶段的计算量来提升模型性能。

后训练扩展定律表明,即使模型参数保持不变,通过增加推理阶段的计算量,也可以显著提升模型的性能

而推理扩展定律(Inference Scaling Law)则强调在推理阶段通过增加计算资源来提升模型性能的原则。

提到这两个定律,不得不提到测试时计算(test-timi compute ),测试时计算可以被看做是实现后训练扩展定律和推理扩展定律的关键手段。

那么什么是测试时计算?

测试时计算是一种在模型推理阶段通过优化计算资源分配来提高模型性能的方法。与预训练相比,测试时计算借助强化学习、原生思维链和更长的推理时间,能够在面对复杂问题时,能够智能地分配计算资源,用最经济的成本提供更高效和准确的答案。

OpenAI推出的O1推理模型正是靠测试时计算实现的。即在训练好的O1模型回答问题时,也就是在推理阶段,给他更多时间和算力,让它自己从自己的回复中得到更好的答案。

在OpenAI提供的O1模型后训练阶段的缩放定律图标显示,随着强化学习时间和推理思考时间的增长,O1模型性能得到显著提升。

不仅OpenAI,微软CEO Satya Nadella在微软Ignite大会上也直言,看到了“测试时计算”新的扩展规律的出现,并表示微软Copilot的 "深入思考"功能也是利用这一规律来解决更难的问题。

实际上,OpenAI O1模型的推出将预训练Scaling Law范式带向了推理层的Scaling Law,国内企业也纷纷追随OpenAI脚步上线推理模型。

这两天,国内DeepSeek扔出重磅炸弹,上线了全新的推理模型 DeepSeek-R1-Lite-Preview,性能直逼O1。背后也同样是推理层的Scaling Law在发挥作用。

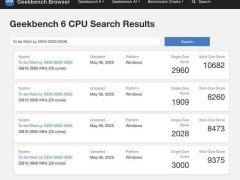

DeepSeek-R1在数学和编程方面与O1-preview相当,甚至在一些竞赛中已经领先O1。

DeepSeek之所以能有如此强势的推理能力,很重要的一点就是他们采用了超长推理时间。官方表示,DeepSeek R1 系列模型推理过程包含大量反思和验证,思维链长度可达数万字。随着思考长度的增加,模型性能在稳步提升。

最近,一反常态的月之暗面,也在成立一周年之际,向外界公布了其数学模型k0-math的进展情况,要知道此前月之暗面的唯一核心在C端产品Kimi身上。

据了解,k0-math采用了强化学习和思维链推理技术,也是Open AI o1系列背后的关键技术。

杨植麟早已预见,随着训练数据达到上限,推理层的Scaling Law想象空间更大,也因此在推理模型上早早准备并上线。他表示,Open AI o1的变化其实可以预测,接下来会越来越关注基于强化学习(RL)的方法去“Scale”。

国内还有阿里、昆仑万维等也都上线了相关的推理大模型产品,无论从技术实现角度还是可落地性角度,Scaling Law已经从预训练向推理层转向。

结尾

大模型预训练的Scaling Law之所以能跑出来,是因为在当时的条件下,这是投入与回报最佳的Scale up路线。

然而,站在历史角度上看,每个技术曲线的Scaling law都有其寿命,不存在一招吃遍天下的情况。

正如摩尔定律最初定义的是集成电路中晶体管数量每两年翻一番,但随着时间的推移,这一规律在新技术的推动下不断扩展,成为广义摩尔定律,甚至超越之前的发展速度一样。

在AI领域,虽然短期内可能会遇到技术瓶颈或成本效益比下降的问题,但从长远来看,AI的软硬件能力仍然会以每十年六个数量级的速度呈指数增长。

这种增长将通过多种创新路径得以实现,包括但不限于算法优化、硬件加速、新型计算架构等,共同维持AI技术的快速发展趋势。

即使Scaling Law真的撞墙,前代技术的商业化应用红利依然会持续很久。